Petite pause fiscale…

😉

Les objectifs de la liberté

Avec son livre The Ends of Freedom – Reclaiming America’s Lost Promise of Economic Rights (Les objectifs de la liberté – Retrouver la promesse perdue des droits économiques des États-Unis), l’économiste Mark Paul «propose un programme politique complet visant à atteindre une version plus étendue et plus durable de la liberté aux États-Unis. Parmi les droits qu’il présente figurent le droit à un bon emploi, le droit à l’éducation, le droit aux services bancaires et financiers, et le droit à un environnement sain».

Avec son livre The Ends of Freedom – Reclaiming America’s Lost Promise of Economic Rights (Les objectifs de la liberté – Retrouver la promesse perdue des droits économiques des États-Unis), l’économiste Mark Paul «propose un programme politique complet visant à atteindre une version plus étendue et plus durable de la liberté aux États-Unis. Parmi les droits qu’il présente figurent le droit à un bon emploi, le droit à l’éducation, le droit aux services bancaires et financiers, et le droit à un environnement sain».

Introduction : L’auteur présente les principaux constats du rapporteur de l’ONU sur l’extrême pauvreté et les droits de la personne faits en 2017 après sa visite de nombreuses villes et régions rurales des États-Unis. Ces constats étaient vraiment désolants, soulignant entre autres la forte présence de l’extrême pauvreté et de la misère dans un des pays les plus riches de la planète. Il a ajouté que ce pays cherche davantage à protéger les libertés négatives (absence d’entraves) que les libertés positives (possibilités de faire quelque chose), négligeant ainsi les interventions pour lutter contre la pauvreté en échange de droits que ces personnes ne peuvent pas exercer. Avec ce livre, l’auteur entend proposer des interventions visant plutôt la défense et la promotion des libertés positives.

Première partie – La liberté aux États-Unis

1. Les États d’Amérique : L’auteur présente de nombreuses données montrant l’ampleur des inégalités aux États-Unis sous bien des facettes, dont sur le logement (aussi bien chez les locataires que par la baisse de l’accessibilité à la propriété et la hausse de l’itinérance); sur l’augmentation de la valeur des actifs nets des plus riches (même durant la pandémie de COVID-19); sur la montée de l’insécurité alimentaire; sur l’environnement et la pollution touchant plus les plus pauvres; sur la discrimination sexuelle et raciale; sur les hausses de revenus concentrées chez les plus riches; sur la stagnation de l’espérance de vie, stagnation qui camoufle sa hausse chez les plus riches et sa baisse chez les plus pauvres et même au sein de la classe moyenne; sur la baisse de la syndicalisation; sur la démocratie en danger, de plus en plus contrôlée par les plus riches; sur le choix du capitalisme néolibéral et ses conséquences sur les inégalités de toutes sortes; sur la fin du rêve américain et sur les facteurs qui ont causé cette fin. Il souligne que ces inégalités avaient pourtant diminué au cours des 30 années suivant la Deuxième Guerre mondiale, montrant que la hausse des inégalités survenue par après n’était pas inévitable et que sa baisse n’est pas non plus survenue par hasard, mais par l’adoption de politiques progressistes. Il ajoute que le succès du néolibéralisme repose en grande partie sur l’utilisation dénaturée du concept de liberté, probablement la valeur la plus ancrée dans la société des États-Unis.

2. Capitalisme et liberté : En 1987, le président des États-Unis de l’époque, Ronald Reagan, a annoncé son intention de modifier la constitution de ce pays pour obliger tous les gouvernements à présenter des budgets sans déficits et pour inscrire quatre libertés économiques : le droit de travailler (pour diminuer le pouvoir des syndicats), celui de payer le moins d’impôt possible (notamment en abolissant tous les programmes de redistribution de la richesse, même pour les plus pauvres), le droit à la propriété (même quand elle va à l’encontre de droits de la personne ou si on doit exproprier quelqu’un) et le droit de participer au libre marché et de signer tout contrat sans que le gouvernement s’en mêle (cela inclut d’annuler l’interdiction du travail des enfants, entre autres). Ce serait de ces principes que vient le concept de néolibéralisme. L’auteur explique ensuite l’absence de fondements de ces supposés droits naturels en racontant l’histoire de la pensée économique, en insistant notamment sur les contributions de Keynes, de Hayek, de la Société du Mont-Pèlerin et encore plus, de Friedman, qui a conseillé les gouvernements de Reagan et des deux Bush. L’auteur conclut en observant l’échec du néolibéralisme et de la promotion des libertés uniquement négatives, notamment avec une population moins éduquée, plus malade, mal logée, mal payée et mal nourrie, avec en plus des milieux de travail plus toxiques et une croissance moins forte qu’auparavant, avec les politiques keynésiennes.

3. L’autre liberté de l’Amérique : Ironiquement, l’auteur rappelle qu’un autre président des États-Unis a déjà lui aussi promis de modifier la constitution pour y inscrire au nom de la liberté les droits au travail et à la vie. Il parle d’un discours de Franklin Delano Roosevelt datant de 1944, quand la victoire des Alliés était rendue certaine. Par contre, ce président n’associait pas la liberté au libre marché comme Reagan, mais à la sécurité physique, morale, sociale et économique (avec moins d’inégalités et de pauvreté). Bien avant Roosevelt, Thomas Payne avait tenu des propos semblables sur l’importance des libertés positives dans son pamphlet Common Sense (ainsi que dans d’autres textes), paru en 1776, quelques mois avant la signature de la Déclaration d’indépendance des États-Unis, pamphlet qui allait bien plus loin que Roosevelt dans les moyens à prendre pour mettre de l’avant ces droits et libertés, proposant un État-providence plus généreux et complet que ceux qui ont existé par la suite. Il aborde ensuite les propositions d’un autre auteur (Alexander Hamilton, premier Secrétaire au Trésor) quelques années plus tard; les mesures adoptées sous Abraham Lincoln (président de 1860 à 1864) allant dans ce sens; l’abolition de l’esclavage en 1865; les principales mesures du New Deal dans les années 1930; l’entrée en guerre des États-Unis en 1941 et ses impacts sur les libertés positives; les huit libertés économiques positives mises de l’avant par Roosevelt en 1944; l’absence des droits civils dans les libertés promues par Roosevelt, ce qui a approfondi les inégalités raciales; la lutte pour les droits civils à partir de 1955, la contribution majeure de Martin Luther King et les liens entre ces droits et la liberté économique; les luttes subséquentes pour les droits économiques.

Deuxième partie – Les droits économiques

4. Le droit au travail : L’auteur présente la contribution de Harry Hopkins (un conseiller majeur de Roosevelt) à la lutte contre la pauvreté, dont la mise sur pied dans les années 1930 de nombreux programmes qui ont fourni du travail (notamment dans des emplois pour des travaux publics) à des millions de travailleur·euses (en leur redonnant la fierté de contribuer concrètement au rétablissement du pays après la Grande Dépression) et qui ont permis la construction ou l’amélioration d’écoles, de routes, d’aéroports, d’égouts, de terrains de jeu, etc. Il analyse ensuite les conséquences du chômage de nos jours, notamment au cours de la pandémie de COVID-19, qui donne aux employeurs un pouvoir exorbitant sur le marché du travail. Il dénonce aussi le concept de taux de chômage naturel que la Fed (banque centrale des États-Unis) utilise pour remplir son mandat de viser l’emploi maximum, car ce concept impossible à mesurer donne encore plus de pouvoir aux employeurs. Il recommande :

- de viser le plein emploi avec entre autres la création d’un nouveau programme permanent d’emplois dans les travaux publics (appliquant le principe de la garantie d’emplois décrite dans ce billet et dans le livre qu’il présente, livre que l’auteur cite, d’ailleurs);

- de rehausser la cible d’inflation de la Fed;

- d’adopter des mesures favorisant la syndicalisation pour équilibrer le rapport de force entre les travailleur·euses et les employeurs.

5. Le droit au logement : Les personnes itinérantes vivent souvent plus d’un problème, la perte de leur logement étant en général due à une autre malchance. Même si elles ne sont pas responsables de leur situation, elles ont trop souvent honte et se sentent coupables. On estime que l’itinérance touchait en 2020 plus de 4 millions de personnes aux États-Unis chaque année, dont 30 % faisaient partie d’une famille avec enfants. En plus, 11 millions de ménages représentant 24 millions de personnes consacraient plus de 50 % de leurs revenus à leur loyer. Malgré les promesses et les programmes incitatifs, le taux de propriété du logement est à la baisse aux États-Unis et est moins élevé que dans bien des pays riches. L’auteur a participé avec des organismes voués au logement à présenter des recommandations visant à fournir à toute la population des logements de qualité. Ils recommandaient entre autres d’augmenter considérablement les investissements gouvernementaux en logement social et d’instaurer des mécanismes de contrôle des loyers. Il présente ensuite en détail le fonctionnement et les avantages de ces deux propositions. Sa démonstration sur les avantages du contrôle des loyers mériterait un billet à elle seule, tellement il démolit avec rigueur la théorie économique orthodoxe sur ce sujet avec des constats tirés d’études empiriques.

6. Le droit à l’éducation : L’auteur définit le concept de biens publics et explique que le marché n’a rien à faire dans la production et la vente de ces biens, et que l’éducation est un des biens publics les plus essentiels pour la démocratie et la liberté. Pourtant, le droit à l’éducation n’est pas enchâssé dans la constitution des États-Unis, notamment parce que ce droit est dévolu aux États. Il est d’ailleurs de nos jours garanti dans chaque État, mais au début, il ne portait que sur l’éducation au primaire. Il a fallu attendre les années 1940 pour que ce droit s’applique aussi à l’éducation au secondaire, alors que les États-Unis se démarquaient positivement sur cet enjeu par rapport aux autres pays, avance qui a contribué à la fois à bâtir une démocratie engagée, à améliorer la liberté des citoyen·nes et à faire croître fortement son économie et sa productivité. Par contre, ce système était offert de façon très inégale selon le genre, l’ethnie et la richesse, inégalités dues en bonne partie au fait que l’éducation postsecondaire n’a jamais été gratuite. Même s’il existe des collèges publics, la plupart sont privés et coûteux, ce qui explique l’endettement important des personnes qui y sont allées. Il aborde ensuite :

- la nécessité de la gratuité des études postsecondaires, un bien public qui devrait être accessible gratuitement à tou·tes les citoyen·nes;

- l’argument néolibéral prétendant que les études postsecondaires sont uniquement un investissement personnel pour rehausser son capital humain, argument entendu fréquemment ici aussi, entre autres lors de la grève étudiante de 2012;

- les principaux arguments qui appuient la proposition de la gratuité des études postsecondaires;

- la faiblesse des arguments de ses opposant·es;

- les avantages de l’augmentation du nombre de places dans les services de garde et dans les maternelles, et ceux de leur gratuité.

7. Le droit aux soins de santé : L’auteur raconte la nomination de Frances Perkins, première femme de l’histoire des États-Unis à siéger dans un cabinet présidentiel, plus précisément au poste de secrétaire au Travail. Elle a notamment contribué à créer le système de sécurité sociale (pour les personnes âgées de 65 ans et plus), le salaire minimum, les prestations pour accident de travail et l’assurance-chômage, mais sans réussir à créer un système public, universel et gratuit de santé malgré ses efforts, en raison de l’opposition de lobbys puissants. Si quelques programmes de santé ont été adoptés par la suite (comme Medicaid et Medicare), les États-Unis demeurent le seul pays riche sans un système de santé universel et gratuit. Il ajoute que le système privé de santé des États-Unis est de loin le plus cher du monde, mais loin d’être le plus efficace, en plus d’être une des causes principales des faillites personnelles.

8. Le droit à un revenu de base et aux services bancaires : Même si la pandémie de COVID-19 a tué bien des gens et a causé la récession la plus profonde depuis la Grande Dépression, le taux de pauvreté a baissé de moitié en 2020 grâce aux programmes gouvernementaux améliorés ou créés de façon ponctuelle, notamment ceux qui ont distribué des sommes importantes aux personnes touchées par la pandémie, que ce soit en raison de la maladie ou de la perte d’un emploi. L’auteur décrit le fonctionnement de ces programmes et leurs effets bénéfiques sur la pauvreté. Ces programmes étant demeurés temporaires, le taux de pauvreté a augmenté considérablement à la fin de ces programmes, mais moins qu’il avait baissé. Il conclut que ces mouvements importants de la pauvreté ont prouvé qu’elle est un choix politique. Il raconte ensuite l’histoire des programmes de lutte contre la pauvreté depuis le New Deal, en insistant sur l’abolition du programme d’aide sociale par le gouvernement de Bill Clinton et ses conséquences désastreuses en faisant non seulement augmenter le taux de pauvreté, mais en la rendant encore plus profonde. Il rappelle que les républicains ont déjà adopté un programme de revenu minimum garanti (en fait, d’impôt négatif), mais que le sénat a rejeté. Il présente ensuite les critères et le fonctionnement d’un revenu minimum garanti qu’il juge idéal. Il aborde ensuite le droit aux services financiers et bancaires.

9. Le droit à un environnement sain : L’histoire des problèmes environnementaux des États-Unis est marquée par l’inconscience de ses entreprises, de ses politicien·nes et de la population face à ces problèmes, inconscience qui a commencé à prendre fin lors des épisodes de smog et de pluies acides dans les années 1960 en raison de décès subits, dont près de 200 à New York lors d’un seul événement, mais aussi en raison de la multiplication des désastres environnementaux, dans un contexte d’absence complète de réglementation environnementale. Ces événements ont entraîné la création de l’Agence de protection de l’environnement (EPA) et l’adoption de plusieurs lois (et des règlements associés), dont le Clean Air Act, en 1970. Si ces lois ont permis une amélioration spectaculaire de la qualité de l’air et des eaux, elles n’ont pas permis d’empêcher complètement les désastres du genre, dont ceux survenus à Flint de 2014 à 2019, ni les dizaines de milliers de décès annuels aux États-Unis en raison de la pollution de l’air (ni les millions de décès prématurés sur la planète). Cela dit, le problème actuel le plus grave est certainement le réchauffement climatique dû aux émissions de gaz à effet de serre (GES). Malheureusement, en se reposant presque uniquement sur des solutions de marché, comme les taxes sur le carbone, il sera impossible de maintenir le réchauffement à un niveau «acceptable». Il présente ensuite d’autres façons plus efficaces pour limiter la hausse des températures (inspirées grandement par les mesures proposées dans le Green New Deal), touchant cette fois des changements à notre mode de vie, alliant les mesures vertes à des mesures sociales et économiques.

Partie III : Un budget pour les citoyen·nes

10. Comment le financer? : L’auteur est bien conscient que ses propositions vont coûter cher, mais que cela est loin de représenter un problème insoluble, surtout pour un pays aussi riche que les États-Unis, comme il le démontre clairement. Il aborde ensuite :

- le rôle de la banque centrale sur la croissance économique, sur l’ampleur du fardeau de la dette et sur le financement des services publics;

- les dépenses dans les services publics qui peuvent être considérées comme des investissements, car ces services (éducation, infrastructures, logement, etc.) ne font pas augmenter que la demande à court terme, mais aussi le potentiel de l’économie à long terme;

- la sous-utilisation des ressources économiques, humaines et autres, qui s’observe presque chaque année, mais qui peut diminuer avec des mesures gouvernementales appropriées;

- l’impact encore plus positif des investissements gouvernementaux quand l’offre est trop faible;

- le contrôle des prix pour lutter contre l’inflation;

- la réallocation des budgets gouvernementaux et les hausses d’impôt qui permettent d’améliorer la quantité et la qualité des services publics (mesures délicates, mais souvent nécessaires);

- une réforme fiscale pour corriger les iniquités actuelles, notamment avec un impôt sur la richesse qui ne ferait pas qu’augmenter les revenus de l’État, mais diminuerait en plus le pouvoir exorbitant des riches qui transforment nos démocraties en ploutocraties.

L’auteur ajoute que l’effet de cet impôt serait plus important avec une entente internationale qui limiterait les déplacements de capitaux.

Conclusion : L’auteur conseille de toujours revenir aux idéaux des fondateurs des États-Unis pour mieux comprendre l’histoire de ce pays. On s’aperçoit alors encore plus clairement du trou qu’il reste à combler sur les droits économiques. Il devient en effet évident que jamais la pauvreté et l’insécurité économique n’ont cadré avec le pays qu’ils voulaient construire. Le but de ce livre était justement de montrer que la pauvreté et l’insécurité économique existent parce qu’elles sont le résultat de choix politiques et économiques liés à des idéologies, et qu’il est possible de faire des choix mieux inspirés.

L’auteur ajoute qu’il n’a pas pu aborder tous les droits économiques et qu’en choisissant les sept qu’il trouve les plus importants, il a dû laisser de côté d’autres droits, dont le droit à la syndicalisation et aux produits de base (énergie, eau, transport public, etc.). Cela dit, améliorer l’accès aux sept droits qu’il a présentés plus à fond dans ce livre serait déjà un progrès immense dans le contexte actuel. Il ne faut en effet pas penser que les personnes qui bénéficient le plus du néolibéralisme se laisseront faire! Et elles sont puissantes. Il faudra donc réunir tous les appuis possibles dans la société et s’organiser. De façon plus positive, il ajoute que la gauche n’a jamais été plus présente au sein des institutions politiques.

Et alors…

Lire ou ne pas lire? Lire! Même s’il n’y a pas beaucoup d’idées nouvelles dans ce livre, l’auteur a su les présenter d’une façon efficace, dans une suite logique dont je n’ai pas trouvé de faille qui mérite d’être mentionnée. Dans le contexte des États-Unis, passer des libertés négatives aux libertés positives est tout un mandat, mais il est de plus en plus essentiel. Je n’avais jamais entendu parler de l’auteur avant de lire ce livre (son premier, d’ailleurs), mais je vais tenter de retenir son nom pour être certain de ne pas rater ses prochains! Cela dit, rien n’est parfait. En effet, les 516 notes, surtout des références, mais aussi de nombreux compléments d’information, s’étendent sur 44 pages à la fin du livre, nous obligeant à utiliser deux signets et à passer du texte principal à ces notes de nombreuses fois à chaque chapitre. Mais, bon, cela n’enlève rien à la qualité de ce livre!

L’étude d’Anna Stansbury intitulée Incentives to Comply with the Minimum Wage in the US and UK (Les incitations à respecter le salaire minimum aux États-Unis et au Royaume-Uni) a été publiée en mars 2024 par l’Institute of Labor Economics (IZA). On peut aussi lire un résumé en anglais de cette étude sur cette page.

L’étude d’Anna Stansbury intitulée Incentives to Comply with the Minimum Wage in the US and UK (Les incitations à respecter le salaire minimum aux États-Unis et au Royaume-Uni) a été publiée en mars 2024 par l’Institute of Labor Economics (IZA). On peut aussi lire un résumé en anglais de cette étude sur cette page.

Introduction

L’autrice considère que le salaire minimum est au centre de la protection des travailleur·euses. Si de nombreuses études portent sur son impact sur le marché du travail, on s’est moins intéressé à son respect, même si celui-ci est essentiel pour étudier son impact! Comme le niveau de non-respect du salaire minimum est très difficile à mesurer avec les données existantes, l’autrice se penche plutôt sur les données sur les pénalités (nombre et importance) pour non-respect.

Elle se concentre sur le salaire minimum fédéral et sur le paiement des heures supplémentaires aux États-Unis, et sur le salaire minimum national au Royaume-Uni. Comme ces deux pays ont plusieurs méthodes de vérification, il n’y a pas de source unique de données pour estimer le non-respect de ces lois et règlements. Elle a donc dû construire elle-même une base de données pour ces deux pays.

1. Le contexte et l’approche empirique

On utilise en général l’analyse coût-avantage pour estimer les incitatifs que reçoit une entreprise pour se conformer à une loi ou une réglementation. Dans le cas du salaire minimum, il faut tenir compte à la fois de la probabilité de recevoir des pénalités et de leur niveau, mais aussi de l’effet positif de mieux payer ses employé·es (salaire d’efficience, gains de productivité, baisse du roulement et des frais de formation, etc.). En outre, il est difficile de savoir si une petite entreprise qui paye moins des employé·es que le salaire minimum le fait volontairement ou par ignorance. Par contre, l’autrice ne tient pas compte du coût de la mauvaise réputation d’une entreprise qui paye mal ses employé·es en contrevenant à la loi.

Chose certaine, les infractions à ces lois ne sont pas rares dans ces deux pays, Une enquête tenue aux États-Unis auprès de travailleur·euses à bas salaires a conclu que 68 % des personnes interrogées «avaient subi au moins une violation liée à la rémunération au cours d’une semaine donnée, pour un coût moyen de 15 % du salaire». Des inspections aléatoires dans la restauration rapide et la confection dans le cadre du Fair Labor Standards Act (FLSA, la loi sur les normes du travail des États-Unis), sont arrivées à des taux de non-respect variant entre 40 % et 85 %. L’organisme régulateur du Royaume-Uni estime de son côté que 22 % des travailleur·euses couvert·es par le salaire minimum étaient sous-payé·es en 2019, alors que le salaire minimum était proportionnellement deux fois plus élevé au Royaume-Uni qu’aux États-Unis (61 % du salaire médian par rapport à 31 %). Cette différence fait aussi en sorte qu’une plus forte proportion des travailleur·euses sont couvert·es par cette loi au Royaume-Uni qu’aux États-Unis et que les incitatifs à ne pas la respecter sont plus élevés.

L’autrice s’est servie aux États-Unis de données sur les enquêtes liées à la FLSA et sur les causes entendues en cour. Par contre, elle n’a pas pu obtenir de données sur les poursuites individuelles. Pour le Royaume-Uni, les données qu’elle a obtenues sont plus variées, mais avec moins de détails. Elle s’est donc imposé une recherche approfondie de centaines de poursuites dans des causes de ce type avec les documents juridiques des tribunaux britanniques.

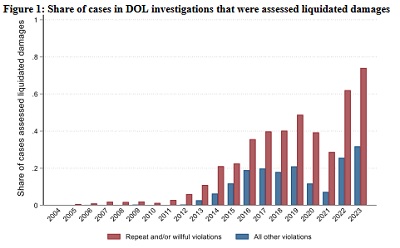

2. États-Unis – Incitations à se conformer à la FLSA

L’autrice a pu assembler des données sur 161 000 cas de 2005 à juillet 2023. Aux États-Unis, les entreprises reconnues fautives doivent rembourser les sommes non payées avec une pénalité du même montant. Si cette pénalité était rarement imposée en début de période (dans seulement 1 % des cas), elle l’était par la suite de plus en plus souvent, soit dans 30 % des cas quand l’infraction ne semblait pas volontaire, mais dans plus de 60 % des cas quand l’infraction était volontaire ou quand il ne s’agissait pas  d’une première infraction, comme on peut le voir sur le graphique ci-contre. Lorsque les infractions sont répétitives, l’employeur peut se faire imposer une «civil monetary penalty» ou CMP (sanction monétaire civile), mais cela est peu fréquent, car seulement 9 % des cas ne sont pas des premières infractions et il est difficile de démontrer l’intention de l’employeur. Ainsi seulement 10 % des infractions répétitives doivent payer des CMP. Dans les cas de violations successives, le ministère du Travail peut saisir des biens produits par l’employeur, ce qui se produit rarement et essentiellement dans l’industrie de la fabrication de vêtements.

d’une première infraction, comme on peut le voir sur le graphique ci-contre. Lorsque les infractions sont répétitives, l’employeur peut se faire imposer une «civil monetary penalty» ou CMP (sanction monétaire civile), mais cela est peu fréquent, car seulement 9 % des cas ne sont pas des premières infractions et il est difficile de démontrer l’intention de l’employeur. Ainsi seulement 10 % des infractions répétitives doivent payer des CMP. Dans les cas de violations successives, le ministère du Travail peut saisir des biens produits par l’employeur, ce qui se produit rarement et essentiellement dans l’industrie de la fabrication de vêtements.

Finalement, l’employeur peut subir des poursuites criminelles dans les pires cas. Cela ne s’est produit que 38 fois entre 1994 et 2020, soit moins de deux fois par année. Et seulement quatre cas se sont terminés avec des amendes (3000 $ en moyenne) et il n’y a eu aucun cas d’emprisonnement, même si la loi le prévoit. L’autrice arrive à la conclusion que les incitatifs à respecter la loi sont assez faibles tant qu’un employeur ne s’est pas fait prendre une première fois. Par contre, si on tient compte des effets du salaire d’efficience mentionnés plus tôt (gains de productivité, baisse du roulement et des frais de formation, etc.), ce sont plutôt les incitatifs à ne pas respecter la loi qui deviennent très faibles, encore plus quand on tient aussi compte de l’aversion au risque, notamment à une mauvaise réputation qui pourrait nuire aux possibilités de promotion des gestionnaires.

L’autrice fait ensuite des calculs pour établir la probabilité de se faire prendre dans des cas de violations et conclut que c’est surtout lorsqu’un·e employé·e dépose une plainte que la probabilité de se faire prendre justifie de respecter la loi, mais que, souvent, ces victimes préféreront chercher un emploi ailleurs que poursuivre leur employeur.

3. Royaume-Uni – Incitations à respecter le salaire minimum

Les données sur la violation de la législation sur le salaire minimum sont encore plus difficiles à trouver et à compiler au Royaume-Uni. Le ministère responsable (le His Majesty’s Revenue and Customs ou HMRC ou encore Recettes et Douanes de Sa Majesté) ne fournit que des données agrégées sur les sommes non payées et sur les pénalités. Lorsque le HMRC découvre une violation au salaire minimum, l’employeur doit rembourser ses salarié·es et verser une somme équivalente en pénalités au cours des 14 jours suivants, ou le double de cette somme s’il traîne les pieds. L’autrice ajoute que ces pénalités ont fortement augmenté depuis une dizaine d’années, certaines ayant été jusqu’à quatre fois plus importantes en 2019 qu’en 2013. Les données du HMRC montrent que, en 2017-2018 et en 2018-2019, les employeurs ont sous-payé leurs salarié·es de £40 millions, leur ont remboursé eux-mêmes 27 % de ces sommes (sans pénalité dans ce cas), 52 % de ces sommes avec une pénalité de 100 %, 13 % avec une pénalité de 200 % et le reste (8 %) avec des pénalités différentes, car ces violations dataient d’avant la hausse des pénalités. Entre 1999 et 2018, il y a eu seulement 14 poursuites, représentant 0,2 % des 7500 cas qui n’ont pas été remboursés directement par les employeurs, celles-ci ayant rapporté en moyenne £5000 par travailleur·euses.

L’autrice calcule ensuite les probabilités de se faire prendre en les jumelant aux sommes à verser et conclut que, comme aux États-Unis, les employeurs n’ont pas vraiment d’incitatifs monétaires à ne pas voler leurs travailleur·euses…

5. Remarques finales

L’autrice conclut que, pour la plupart des employeurs, les systèmes juridiques des États-Unis et du Royaume-Uni ne fournissent pas d’incitatifs suffisants pour s’assurer du respect de la législation sur le salaire minimum. Cela n’est pas étonnant, puisque toutes les recherches sur ce sujet estiment que le taux de non-respect du salaire minimum est relativement élevé.

Si les enquêtes du ministère de la Justice des États-Unis ne constituent pas vraiment un incitatif à respecter la loi, l’autrice ajoute quelques bémols à son analyse :

- les poursuites individuelles peuvent être très coûteuses pour les employeurs reconnus coupables;

- le salaire minimum fédéral est tellement bas que les employeurs auraient beaucoup de difficulté à embaucher des travailleur·euses acceptant un emploi à un salaire plus bas;

- l’autrice a précisé qu’elle ne tenait pas compte de la mauvaise réputation qu’une entreprise qui paye mal ses employé·es en contrevenant à la loi subirait, alors que ce facteur peut à lui seul inciter un bon nombre d’entreprises à respecter la loi;

- les citoyen·nes, même corporatifs, tendent à respecter la loi.

Cela dit, le niveau de respect de la loi pourrait être amélioré en augmentant le nombre d’enquêteur·euses (ce qui augmenterait la probabilité qu’une entreprise contrevenante se fasse pincer) et en prévoyant des pénalités plus importantes. On pourrait aussi faciliter le dépôt de plaintes des travailleur·euses, autre moyen d’augmenter la probabilité qu’un employeur malhonnête se fasse poursuivre. Le vol des salaires pourrait aussi être considéré comme un acte criminel pouvant mener à des peines de prison, comme c’est le cas de presque tous les autres vols (j’ai abordé la question plus large des vols de salaires dans ce billet, qui date toutefois de 2015). Elle ajoute que, dans un contexte de hausse importante du salaire minimum comme le gouvernement des États-Unis compte le faire, il sera important de resserrer les mailles du filet, car les employeurs seront bien plus portés à ne pas respecter un salaire minimum plus élevé.

Et alors…

Je dois dire que, jusqu’aux remarques finales, ce n’était pas le genre d’étude que je préfère. Tout au long de cette étude, l’autrice n’examine le respect de la loi qu’avec l’analyse coût-avantage, facteur qui compte bien sûr, mais qui met de côté bien d’autres comportements humains. C’est le propre des théories économiques orthodoxes de considérer les agents économiques comme des homos œconomicus, sans tenir compte de toutes les autres caractéristiques des êtres humains. C’est ce que fait l’autrice dans près de 30 pages pour finalement en arriver à tenir compte des facteurs sociaux et éthiques de façon très correcte dans ses remarques finales, en précisant même que ces facteurs sont plus importants que la seule analyse coût-avantage. Avant cette conclusion, j’allais dénoncer cette étude et sa méthodologie, tandis que maintenant, je déplore toujours la place qu’elle a accordée à l’analyse coût-avantage, mais je la salue d’avoir su finalement bifurquer en conclusion!

Qui a peur du salaire minimum?

Malgré des progrès évidents dans la perception de la population sur les hausses du salaire minimum, on entend encore des organismes patronaux et des politicien·nes de droite ou de centre droit annoncer des effets désastreux sur le marché du travail lors de toutes les hausses, même faibles. Il est donc pertinent de consulter encore et encore les études empiriques bien faites pour documenter les effets réels de ces hausses.

Malgré des progrès évidents dans la perception de la population sur les hausses du salaire minimum, on entend encore des organismes patronaux et des politicien·nes de droite ou de centre droit annoncer des effets désastreux sur le marché du travail lors de toutes les hausses, même faibles. Il est donc pertinent de consulter encore et encore les études empiriques bien faites pour documenter les effets réels de ces hausses.

L’étude intitulée Who’s Afraid of the Minimum Wage? – Measuring the Impacts on Independent Businesses Using Matched U.S. Tax Returns (Qui a peur du salaire minimum? – Mesurer son impact sur les entreprises indépendantes à l’aide des déclarations fiscales américaines correspondantes) de Nirupama Rao et Max Risch que je présente dans ce billet, dont Arindrajit Dube, un des économistes qui a le plus étudié cette question, recommande la lecture, a été publiée sur quelques sites, dont ceux de l’Internal Revenue Service (IRS) et de l’Université du Michigan, mais celle que j’ai lue, la plus récente, l’a été en mars 2024 sur la page de Nirupama Rao.

Introduction

Les inquiétudes face à des hausses du salaire minimum portent surtout sur la survie des entreprises indépendantes, même si de nombreuses études empiriques montrent que ces hausses n’ont pas d’effets négatifs sur l’emploi total. D’autres chercheur·euses ont observé que les opinions sur la question varient considérablement parmi les propriétaires de ces entreprises. Cette étude est la première à se pencher directement sur l’impact des hausses du salaire minimum sur les entreprises indépendantes.

2. L’analyse des réactions des entreprises à l’aide de données administratives

Pour pouvoir connaître l’impact des hausses du salaire minimum sur des entreprises indépendantes et sur leurs travailleur·euses, les auteur·es ont besoin de sources qui combinent des données sur l’emploi et sur le salaire des travailleur·euses d’entreprises particulières avec des données sur les revenus et les profits des entreprises qui les embauchent. Pour ce, iels ont surtout utilisé les données gouvernementales sur l’impôt des particuliers et des entreprises, en les combinant avec des données tirées du registre des entreprises. En 2015, ces entreprises représentaient 78 % des entreprises privées, embauchaient 46 % des travailleur·euses et cumulaient 52 % des revenus d’entreprises.

Aux États-Unis, seulement 4,3 % des salarié·es payé·es à l’heure travaillent au salaire minimum ou à un salaire inférieur, ce qui représente quand même 3,25 millions de personnes. Cela dit, ces travailleur·euses étaient fortement concentré·es dans quelques industries, plus des deux tiers travaillant en 2013 dans les industries des loisirs et de l’hospitalité (55 %), et du commerce de détail (14 %). Au bout du compte (je vous épargne les détails), leur échantillon de base est formé d’environ 235 000 entreprises par année, de 2010 à 2019, et de 600 000 travailleur·euses (400 000 dans les États ayant connu des hausses de salaire minimum et 200 000 dans ceux qui n’en ont pas eu), en plus de deux autres échantillons formés des travailleur·euses de ces industries âgé·es de 16 à 19 ans et de 20 à 26 ans.

3. Hausses du salaire minimum dans les États et stratégie empirique

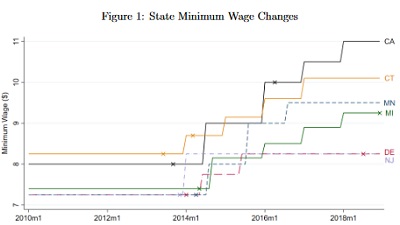

Le graphique ci-contre illustre les hausses du salaire minimum entre 2014 et 2018 dans les six États dont les entreprises et les travailleur·euses à bas salaires serviront de groupe d’analyse (Californie, Connecticut, Delaware, Michigan, Minnesota et New Jersey). Le groupe de contrôle est de son côté formé des entreprises et des travailleur·euses à bas salaires des 25 États qui n’ont connu aucune hausse du salaire minimum entre 2012 et 2018 (Alabama, Géorgie, Iowa, Idaho, Illinois, Indiana, Kansas, Kentucky, Louisiane, Mississippi, Caroline du Nord, Dakota du Nord, New Hampshire, Nouveau-Mexique, Nevada, Oklahoma, Pennsylvanie, Caroline du Sud, Tennessee, Texas, Utah, Virginie, Wisconsin et Wyoming). Les auteur·es constatent que les caractéristiques des entreprises des groupes d’analyse et de contrôle étaient en 2013 très semblables (voir le tableau 1 au haut de cette page). Iels expliquent ensuite la méthodologie qu’iels ont utilisée dans cette étude (partie dont je vous fais grâce).

Le graphique ci-contre illustre les hausses du salaire minimum entre 2014 et 2018 dans les six États dont les entreprises et les travailleur·euses à bas salaires serviront de groupe d’analyse (Californie, Connecticut, Delaware, Michigan, Minnesota et New Jersey). Le groupe de contrôle est de son côté formé des entreprises et des travailleur·euses à bas salaires des 25 États qui n’ont connu aucune hausse du salaire minimum entre 2012 et 2018 (Alabama, Géorgie, Iowa, Idaho, Illinois, Indiana, Kansas, Kentucky, Louisiane, Mississippi, Caroline du Nord, Dakota du Nord, New Hampshire, Nouveau-Mexique, Nevada, Oklahoma, Pennsylvanie, Caroline du Sud, Tennessee, Texas, Utah, Virginie, Wisconsin et Wyoming). Les auteur·es constatent que les caractéristiques des entreprises des groupes d’analyse et de contrôle étaient en 2013 très semblables (voir le tableau 1 au haut de cette page). Iels expliquent ensuite la méthodologie qu’iels ont utilisée dans cette étude (partie dont je vous fais grâce).

4. Impacts sur les entreprises et les travailleurs

Les auteur·es estiment que l’impact des hausses du salaire minimum sur l’emploi dans les entreprises indépendantes vulnérables est très faible. En effet, ces hausses n’entraînent pas en moyenne de réduction significative du nombre d’emplois. Cela dit, iels constatent que :

- ces entreprises ont diminué les embauches, surtout d’adolescent·es (âgé·es de 16 à 19 ans) gagnant moins de 4000 $ par année, en majorité (aux deux tiers) moins de 1000 $ par année;

- cela s’explique par le fait que le taux de maintien en emploi a augmenté, ce qui a réduit les besoins de travailleur·euses à temps partiel peu expérimenté·es;

- le taux de maintien en emploi a augmenté dans toutes les tranches d’âge, mais encore plus chez les travailleur·euses âgées de 25 à 54 ans;

- la main-d’œuvre de ces entreprises est donc devenue plus expérimentée après les hausses du salaire minimum;

- cela ne semble pas avoir nui à l’intégration en emploi des adolescent·es, car leur revenu d’emploi moyen a quand même augmenté entre 2013 et 2018 (en moyenne de 1000 $ de plus que dans les États du groupe de contrôle), même si cette hausse a été moins élevée que pour les jeunes âgé·es de 20 à 26 ans (hausse moyenne de 4000 $ de plus que dans les États du groupe de contrôle);

- les taux d’emploi des jeunes, y compris des adolescent·es, n’a pas baissé pas au cours des années suivant les hausses du salaire minimum;

- comme le taux d’emploi s’est au moins maintenu et que les revenus des travailleur·euses ont augmenté, le coût moyen de la main-d’œuvre a augmenté davantage pour ces entreprises indépendantes que pour celles des États où il n’y a pas eu de hausse du salaire minimum (groupe de contrôle), en moyenne de 7 % en fin de période (2018);

- les revenus moyens de ces entreprises indépendantes ont augmenté en 2018 de 2,1 % de plus que ceux des entreprises indépendantes du groupe de contrôle;

- les revenus moyens des propriétaires de ces entreprises indépendantes (ce qui représente une estimation des profits) ont augmenté en 2018 de 2,7 % de plus que ceux des propriétaires des entreprises indépendantes du groupe de contrôle, ce qui montre que la hausse des revenus a surpassé la hausse des coûts dus à la hausse des salaires;

- ces constats montrent aussi que le coût des salaires de ces travailleur·euses ne représente qu’une faible proportion des revenus de ces entreprises, car, comme les profits ont augmenté, une hausse de 2,1 % seulement des revenus a plus que compensé la hausse de 7 % des coûts salariaux; les auteur·es évaluent que, en moyenne, une hausse de 1,4 % des revenus aurait compensé la hausse de 7 % des salaires, ce qui semble indiquer que les salaires ne correspondaient qu’à 20 % des revenus de ces restaurants; cela fait en sorte qu’une faible hausse des prix est suffisante pour compenser une hausse bien plus importante des salaires (ce que je répète chaque année dans mes billets sur les hausses du salaire minimum au Québec);

- la probabilité qu’une de ces entreprises indépendantes qui était active en 2013 ne le soit plus en 2018 était plus élevée de 0,9 point de pourcentage que celle des entreprises indépendantes du groupe de contrôle; comme ce taux était de 29 %, cela montre que cet impact est significatif, mais de très faible ampleur;

- en fait, le taux de sortie plus élevé n’était statistiquement significatif que dans la restauration, avec un écart de 1,85 point de pourcentage, l’écart des autres entreprises n’étant que de 0,01 point avec un écart-type de 0,44; c’est pourtant dans la restauration que les revenus et les profits ont en moyenne le plus augmenté, ce qui montre la grande diversité des impacts de la hausse du salaire minimum selon les entreprises de ce secteur; les auteur·es précisent que la hausse des revenus et des profits moyens ne s’est appliquée qu’aux restaurants encore en activité, qui peuvent avoir bénéficié de la sortie des restaurants qui n’étaient plus en activité.

5. Impacts dynamiques : sélection, survie et réaffectation

Les auteur·es montrent que ce sont les restaurants les plus productifs et comptant le plus d’employé·es qui ont eu les taux les plus élevés de survie. Il en a été de même pour les nouveaux restaurants qui ont ouvert entre 2013 et 2018, avec des niveaux de productivité bien plus élevés que les restaurants qui ont fermé. Au bout du compte, les hausses du salaire minimum ont entraîné une sélection qui a permis d’augmenter la productivité moyenne dans la restauration de ces États, ce qui correspond au concept de destruction créatrice de Joseph Schumpeter.

Comme l’emploi s’est maintenu, on a aussi observé une hausse du taux de maintien en emploi dans les restaurants demeurés ouverts et une réaffectation des travailleur·euses de restaurants moins productifs vers des restaurants plus productifs et comptant plus d’employé·es. Comme le maintien en emploi a été plus élevé dans les restaurants plus productifs et ayant le plus d’employé·es, ces restaurants ont en plus amélioré leur productivité et ont réduit les embauches d’employé·es jeunes et sans expérience (et leurs dépenses d’embauche et de formation, ce qui a sûrement contribué à la hausse des profits mentionnée plus tôt).

Iels observent aussi que, comme mentionné plus tôt, que les adolescent·es n’ont pas subi de diminution d’emplois ni de revenus, mais ont été embauché·es dans d’autres types d’entreprises. Plus étonnant, les propriétaires des entreprises ayant fermé ont en forte majorité trouvé d’autres emplois, la plupart du temps comme salarié·es, et ont vu leurs revenus augmenter, ce qui montre encore une fois que les restaurants qui ont fermé étaient les moins productifs et procuraient donc moins de profits (ou de revenus) que la moyenne à leurs propriétaires.

6. Conclusion

Comme à peine un million de travailleur·euses ou 1,5 % des salarié·es verraient leur salaire augmenter si le salaire minimum fédéral était haussé, on peut se demander pourquoi l’éventualité d’une telle hausse suscite autant de débats. En plus, cette étude montre que les entreprises qui seraient les plus touchées par une telle hausse seraient en mesure de l’absorber, et même parfois d’en bénéficier. Les auteur·es concluent en précisant que cette étude n’a porté que sur les impacts à court terme de hausses du salaire minimum et que les impacts à long terme pourraient être différents.

Et alors…

Même si j’ai lu des dizaines d’études sur l’impact des hausses du salaire minimum, celle-ci est la première qui porte sur l’impact de ces hausses sur les entreprises indépendantes et les personnes qui y travaillent. Sans surprise, ces effets sont minimes et globalement positifs sur les travailleur·euses à bas salaires, mais, ce qui pourrait surprendre, aussi sur la productivité de ces entreprises. Les constats de cette étude s’ajoutent à ceux des autres études et va dans le même sens. La seule chose qu’on ignore, c’est la limite du salaire minimum qu’on pourrait atteindre sans effets négatifs, mais, chose certaine, nous en sommes encore loin, aussi bien ici qu’aux États-Unis.

On peut aussi lire un compte-rendu de cette étude en anglais dans un court texte publié sur une page de nouvelles de l’Université du Michigan (d’où j’ai emprunté l’image qui accompagne ce billet), ainsi qu’un résumé très bien fait sur la page Twitter de Nirupama Rao.

Santé inc.

Avec son livre Santé inc. – Mythes et faillites du privé en santé, Anne Plourde, docteure en science politique, titulaire d’un postdoctorat sur la privatisation des services de santé et chercheuse à l’Institut de recherche et d’informations socioéconomiques (IRIS), «a voulu confronter cinq mythes sur le privé en santé à la réalité des faits. À la lumière des expériences menées au Québec et ailleurs dans le monde, son constat est implacable : le privé multiplie les échecs depuis un siècle, il ne coûte pas moins cher, n’est pas plus efficace, ne réduit pas les listes d’attente et n’améliore pas la qualité des soins».

Avec son livre Santé inc. – Mythes et faillites du privé en santé, Anne Plourde, docteure en science politique, titulaire d’un postdoctorat sur la privatisation des services de santé et chercheuse à l’Institut de recherche et d’informations socioéconomiques (IRIS), «a voulu confronter cinq mythes sur le privé en santé à la réalité des faits. À la lumière des expériences menées au Québec et ailleurs dans le monde, son constat est implacable : le privé multiplie les échecs depuis un siècle, il ne coûte pas moins cher, n’est pas plus efficace, ne réduit pas les listes d’attente et n’améliore pas la qualité des soins».

Introduction – Le privé en santé, est-ce que ça fonctionne? : L’autrice présente le contexte actuel de crise dans le système public de santé et l’illusion que le recours accru aux services du secteur privé serait une des solutions à cette crise, alors que ce recours, à l’intérieur et à l’extérieur du système public, est en croissance depuis des décennies sans amélioration de la situation. Elle énonce ensuite ses objectifs en écrivant ce livre, dont celui de répondre à la question du titre de cette introduction. Elle aborde ensuite les grandes lignes du contenu des chapitres de ce livre; les concepts qu’elle y utilisera; les deux modèles de recours au privé dans la santé; une esquisse de la réponse à sa question.

Faillite 1. Le privé en santé échoue depuis un siècle – Mythe 1. Le système de santé est essentiellement public : L’autrice démolit ce mythe en rappelant que notre système de santé était supposé devenir à 100 % public lors de la Révolution tranquille, notamment parce que le système privé en force partout ou presque avant la création de l’assurance hospitalisation en 1961 et de l’assurance maladie en 1970 avait échoué à offrir des services qui répondaient aux besoins de la population. En fait, cet objectif de nationalisation complète n’est jamais passé proche d’être réalisé par manque de volonté politique. L’autrice se penche ensuite sur l’état déplorable des services de santé avant la création des deux assurances (hospitalisation et maladie) et sur la survie des services privés après cette date en raison de la force des lobbys du privé et du conservatisme de nos gouvernements.

Faillite 2. Le privé en santé échoue à réduire les coûts – Mythe 2. Le privé coûte moins cher : Même si ce mythe est déboulonné depuis longtemps, même dans la population, il demeure qu’il fut l’argument à la base de bien des privatisations dans le secteur de la santé. L’autrice fait le tour des nombreuses facettes du privé en santé, avec des exemples qui montrent qu’il est inévitablement plus cher, moins accessible et moins efficace, et ce, peu importe le domaine d’intervention. Elle explique aussi les facteurs qui expliquent ces constats désolants, notamment durant la pandémie de COVID-19.

Faillite 3. Le privé en santé échoue à être efficace – Mythe 3. Le privé est plus efficace : Pour un certain ministre de la CAQ et sûrement pour d’autres, le privé est plus efficace que le public par définition, C’est pratique de dire cela, car ce genre d’affirmation n’exige aucune preuve, aucune démonstration. Il en est de même de celle qui prétend que les gestionnaires du privé ont des compétences bien supérieures à celles des gestionnaires du public. Pourtant, les frais d’administration sont systématiquement plus élevés dans le secteur privé et c’est quand le secteur public tend à imiter le secteur privé, entre autres avec la nouvelle gestion publique, que ces frais explosent dans le secteur public. L’autrice aborde aussi les vagues de fusions des établissements et la disparition des conseils d’administration élus, au grand plaisir du milieu des affaires; l’augmentation du temps consacré à des tâches administratives; le mode de rémunération des médecins caractérisé par sa lourdeur administrative, malgré tout imité pour le financement des hôpitaux (financement à l’activité); la diminution de l’accès aux services de première ligne et la hausse de l’encombrement dans les urgences; l’échec (non pénalisé) des «super-cliniques».

Faillite 4. Le privé en santé échoue à désengorger le public – Mythe 4 : Le privé aide à réduire les listes d’attente dans le public : Il échoue en premier lieu parce qu’il vampirise les ressources du secteur public, ses services ne s’ajoutant pas à ceux du public comme le prétend le gouvernement, mais détournant plutôt les ressources du public vers le privé, et ce, dans tous les pays où de telles «solutions» ont été essayées. La raison de cette vampirisation est partout la même, car le nombre de professionnel·les de la santé n’augmente pas par magie quand l’État sous-traite des chirurgies aux super-cliniques. L’autrice aborde aussi la hausse de la proportion d’emplois dans le secteur privé dans les soins de santé et d’assistance sociale entre 1987 et 2000; les facteurs qui expliquent cette hausse; la réglementation insuffisante pour limiter les transferts des professionnel·les de la santé vers le secteur privé; le cas particulier et encore plus néfaste de la migration des psychologues vers le secteur privé; l’impact des soins virtuels sur la privatisation des services de santé.

Faillite 5. Le privé en santé échoue à préserver la qualité et l’équité – Mythe 5. Le privé améliore la qualité des soins : L’autrice explique que ce mythe repose sur un raisonnement basé sur les théories économiques orthodoxes et même néoclassiques, et non pas sur des observations empiriques. J’ajouterai que le «marché» de la santé n’a rien à voir avec un libre marché pleinement concurrentiel et que, en conséquence, même si on croit aux bienfaits du libre marché, ceux-ci ne s’appliquent pas à celui de la santé. Elle montre ensuite que la qualité des services de santé s’est détériorée dans tous les territoires (pays, territoires, provinces et autres) qui ont cru en ce mirage. Par exemple, le bilan des décès dus à la COVID-19 fut carrément accablant pour les établissements privés, au Québec comme dans toutes les provinces canadiennes, tellement que même le gouvernement de la CAQ, on ne peut plus favorable au privé, a même parlé de les nationaliser (mais, il a ensuite renoncé à le faire…). Elle revient sur les problèmes liés à la télémédecine privée, puis aborde la contradiction entre la recherche de profits maximaux et la livraison de services de qualité supérieure, notamment en prévention, d’autant plus que cela réduirait la demande pour leurs services curatifs les plus profitables; le conflit d’intérêts des entreprises pharmaceutiques entre la production de médicaments efficaces et la maximisation des profits, comme la crise des opioïdes l’a montré clairement; les décès innombrables dus aux brevets qui créent des monopoles; le développement d’un système de santé à deux vitesses; les conséquences de l’absence presque complète de services publics dans les soins dentaires et oculaires; les passerelles entre les services de santé couverts par le régime public et ceux qui ne le sont pas.

Conclusion – Déprivatiser les services de santé : L’autrice se penche ici sur un autre mythe, celui de l’inévitabilité du recours au privé pour le financement et la prestation des services de santé. Elle propose la seule solution pour faire face aux cinq mythes déconstruits dans ce livre (en fait six avec celui-ci) : déprivatiser l’ensemble des services de santé, mesure qui est nécessaire, mais pas suffisante. Elle recommande donc qu’on travaille aussi à décentraliser, à démocratiser et à démédicaliser les services, en mettant en plus l’accent sur la prévention et sur les services de première ligne. Elle ajoute que ses recommandations sont expliquées plus en détail dans ce document publié par l’IRIS qu’elle a rédigé avec deux collègues. Il faudra aussi améliorer les conditions de travail dans le secteur public, et pas seulement les salaires. Elle parle aussi de démocratiser la gestion des établissements publics et surtout de garantir la pleine autonomie aux professionnel·les de la santé, tout en allégeant leurs tâches administratives. Elle propose ensuite une série de mesures pour réaliser ces recommandations, puis conclut en répondant par la négative à la question du titre de l’introduction de ce livre.

Et alors…

Lire ou ne pas lire? Lire! Il s’agit du livre que j’ai lu qui contient le plus de faits et d’arguments démontrant le coût plus élevé du privé en santé et son inefficacité. On pourrait trouver qu’il y a beaucoup de répétitions dans ce livre, mais, malgré la recension des échecs continuels du secteur privé en santé, les idéologues de ce gouvernement (et de ceux qui l’ont précédé) ne cessent de vanter l’efficacité du secteur privé et les économies (imaginaires) qu’il procure dans les services de santé. Alors, ce sont surtout les erreurs des gouvernements qui se répètent! Je tiens aussi à souligner la qualité de l’écriture qui permet d’éviter les lourdeurs qu’on pourrait craindre dans un livre qui contient beaucoup d’informations techniques. Autre bon point, les 166 notes, aussi bien des références que des compléments d’information, sont en bas de page.

On peut aussi lire un autre résumé intéressant de ce livre, tout à fait complémentaire à ce billet, accompagné d’une entrevue avec l’autrice dans cet article de Pivot.

Les avantages du plein emploi

Quand j’y pense, je consulte le rapport économique produit chaque année par le Council of Economic Advisers (CEA) à l’intention du président des États-Unis. Par exemple, c’est ce rapport qui m’a permis de produire les billets de cette page (six, en comptant celui-ci). On m’a cette année conseillé la lecture du premier chapitre du rapport de 2024, qui a été publié en mars. C’est aussi bien, car je n’aurais jamais touché à ce rapport de 487 pages! Comme le titre de ce billet l’indique, ce chapitre est intitulé The Benefits of Full Employment. Notons que la table des matières contenant une courte présentation de chacun des sept chapitres du rapport est accessible sur cette page.

Quand j’y pense, je consulte le rapport économique produit chaque année par le Council of Economic Advisers (CEA) à l’intention du président des États-Unis. Par exemple, c’est ce rapport qui m’a permis de produire les billets de cette page (six, en comptant celui-ci). On m’a cette année conseillé la lecture du premier chapitre du rapport de 2024, qui a été publié en mars. C’est aussi bien, car je n’aurais jamais touché à ce rapport de 487 pages! Comme le titre de ce billet l’indique, ce chapitre est intitulé The Benefits of Full Employment. Notons que la table des matières contenant une courte présentation de chacun des sept chapitres du rapport est accessible sur cette page.

Introduction

Ce document porte sur «les effets économiques d’un marché du travail tendu – en d’autres termes, lorsque les emplois sont abondants par rapport aux personnes qui en cherchent – sur les familles de travailleur·euses et la macroéconomie».

Qu’est-ce que le plein emploi et pourquoi est-il important?

Les auteur·es montrent que le concept de plein emploi est loin d’être nouveau, notamment en citant un texte britannique datant du XVIIIe siècle. Iels considèrent qu’une économie connaissant le plein emploi est celle «dans laquelle les travailleur·euses capables et désireux·euses de travailler peuvent obtenir les emplois et les heures de travail qu’iels souhaitent». D’autres économistes le définissent par un taux de chômage le plus bas possible, mais sans créer de pression inflationniste. Les auteur·es expliquent ensuite correctement que le taux de chômage sans pression inflationniste n’est pas le meilleur indicateur pour définir un concept qui parle d’emploi, d’autant plus que l’estimation de cet indicateur repose sur des hypothèses pas toutes observables et varie considérablement selon les économistes. En outre, ce concept ne tient pas compte de certaines défaillances du marché, dont la présence de comportements discriminatoires (femmes, personnes noires, personnes handicapées, etc.) et les pouvoirs monopolistiques des employeurs qui leur permettent de payer des salaires moins élevés qu’ils le feraient si ce marché était vraiment concurrentiel. Par contre, ce pouvoir diminue considérablement dans une situation de plein emploi qui augmente le rapport de force des travailleur·euses et les aide à trouver des emplois ailleurs. Dans ce cas, les employeurs avec des pouvoirs monopolistiques subissent des taux de roulement plus élevés et des difficultés de recrutement qui les incitent à améliorer les conditions de travail qu’ils offrent, d’autant plus que le plein emploi est souvent accompagné d’une hausse de la syndicalisation et des arrêts de travail dus à des conflits de travail (grèves et lock-outs).

Cela dit, les auteur·es présentent tout de même d’autres indicateurs qui peuvent suggérer la présence du plein emploi : taux de postes vacants, taux de départs volontaires non liés à la retraite, taux de changements d’emploi, taux de chômage incluant le travail à temps partiel involontaire et les inactifs qui aimerait travailler, etc.

Quelques exemples des avantages du plein emploi

Les auteur.es mentionnent une série d’avantages au plein emploi :

- il réduit les écarts de taux d’emploi et de chômage entre les Noir·es, les hispanophones et les Blanc·hes, notamment ce qu’on appelle les écarts non expliqués (autres que liés à des caractéristiques comme la scolarité et la démographie);

- il les réduit aussi entre les gens plus et moins scolarisés, et entre les hommes et les femmes;

- il les réduit en fait entre tous les groupes favorisés et défavorisés, dont les personnes handicapées;

- en améliorant leur taux d’emploi et de chômage, il permet aux membres de ces groupes d’augmenter leur expérience de travail et leurs compétences, ce qui les aide à long terme, même lors de périodes moins avantageuses;

- il améliore aussi leurs possibilités de promotion ou de changement d’emplois pour des postes offrant de meilleures conditions de travail, notamment salariales;

- comme il permet des augmentations salariales plus importantes, il fait aussi augmenter les revenus des familles, surtout pour celles à faibles revenus;

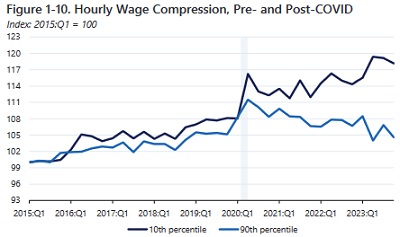

ces tendances expliquent ce qu’on appelle la compression inattendue sur le marché du travail à bas salaires, comme on peut le voir sur le graphique ci-contre, qui montre que le salaire moyen réel (en tenant compte de l’inflation) du 10e percentile a augmenté de 18 % entre le début de 2015 et la fin de 2023, près de quatre fois plus que celui du 90e percentile (5 %), et que plus des trois quarts de cette différence (10 des 13 points d’écart) se sont réalisés depuis le début de la pandémie (2020);

ces tendances expliquent ce qu’on appelle la compression inattendue sur le marché du travail à bas salaires, comme on peut le voir sur le graphique ci-contre, qui montre que le salaire moyen réel (en tenant compte de l’inflation) du 10e percentile a augmenté de 18 % entre le début de 2015 et la fin de 2023, près de quatre fois plus que celui du 90e percentile (5 %), et que plus des trois quarts de cette différence (10 des 13 points d’écart) se sont réalisés depuis le début de la pandémie (2020);- les auteur·es précisent que cette amélioration ne provient pas entièrement du marché du travail serré (ou du plein emploi), car les changements structurels de ce marché en raison de la pandémie ont aussi contribué à cette compression, mais qu’il est indéniable que le plein emploi fut le principal facteur de cette amélioration;

- iels montrent aussi que la compression fut encore plus importante pour les familles noires et encore plus pour les cheffes des familles monoparentales.

Les auteur·es expliquent que ces groupes sont toujours les premières victimes des récessions et sont à l’inverse les premiers bénéficiaires des reprises. En plus, la discrimination devient plus coûteuse pour les employeurs quand ils ont des difficultés de recrutement et des taux de roulement plus élevés, ce qui réduit grandement leurs pouvoirs monopolistiques.

Les moyens d’atteindre le plein emploi et d’y demeurer

Si les États-Unis ont connu plusieurs périodes de plein emploi (ou presque) depuis la fin de la Deuxième Guerre mondiale (au moins 10), elles ont rarement duré plus de quelques trimestres. Alors que les auteur.es estiment que ce fut le cas dans près des deux tiers (64 %) des trimestres entre 1949 et 1981, ce ne le fut que dans 38 % des trimestres depuis 1982. Iels considèrent que l’utilisation de la courbe de Phillips (relation entre le taux de chômage et l’inflation) comme base des politiques monétaires et fiscales explique en grande partie la faible fréquence des périodes de plein emploi depuis 1982. Heureusement, la remise en question de la pertinence de cette courbe a amené les décideur·euses à en tenir de moins en moins compte, surtout en raison de la longue période de basse inflation jumelée à de faibles taux de chômage, phénomène qui contredit les bases de cette courbe. De même, il est clair que la période actuelle de haute inflation n’a rien à voir avec le bas taux de chômage, mais s’explique plutôt par des chocs d’offre dus surtout à la pandémie de COVID-19, aux changements climatiques (sécheresses, inondations, feux de forêt, etc.) et aux conflits armés, surtout en Ukraine. De même, la forte baisse de l’inflation depuis le milieu de 2022 n’a pas été accompagnée par une hausse importante du taux de chômage, mais bien par le rétablissement des chaînes d’approvisionnement.

Il n’est toujours pas évident de connaître précisément les facteurs qui expliquent ces mouvements qui diffèrent considérablement des relations entre l’inflation et le taux de chômage qui semblaient si claires il y a quelques décennies. Cela dit, compte tenu des avantages indéniables du plein emploi exposés plus tôt dans ce document, surtout pour les groupes les plus désavantagés, les gouvernements devraient adopter des mesures qui permettent de s’y maintenir, notamment avec des politiques expansionnistes dès que le marché du travail devient moins serré. De même, les banques centrales devraient abandonner leurs mesures restrictives le plus vite possible pour éviter une récession qui serait actuellement inutile pour combattre l’inflation qui s’approche de leurs objectifs sans qu’on ait connu de hausse notable du taux de chômage.

En plus des mesures déjà abordées plus tôt, les auteur·es soulignent l’importance d’autres mesures pour s’approcher du plein emploi et y demeurer le plus longtemps possible :

- des services de garde accessibles et abordables, car leur absence constitue une barrière importante pour que les femmes avec de jeunes enfants puissent accéder au marché du travail et y demeurer;

- des mesures pour contrer la discrimination basée sur le genre, l’ethnie et les handicaps, aussi bien sur l’embauche que sur les salaires, notamment par l’implantation de programmes d’action positive;

- du logement abordable, notamment dans les régions où l’activité économique est solide;

- l’élimination d’autres barrières, comme la concentration des entreprises (qui est associée à des pouvoirs monopolistiques); l’amélioration de l’accès à l’éducation supérieure; la correction de quelques mesures fiscales qui pénalisent les revenus d’emploi; l’amélioration de la disponibilité du télétravail, actuellement très variable selon les régions et les employeurs; ses mesures pour éviter la perte de compétences quand une personne quitte le marché du travail trop longtemps en raison d’une récession, par exemple en généralisant le travail partagé (plutôt que le seul remplacement de revenu par l’assurance-chômage), comme dans de nombreux pays européens.

Conclusion

Malgré l’imprécision des estimations du taux de chômage sans pression inflationniste, on a vu qu’un taux de chômage sous la barre de 4 % apporte de nombreux bienfaits liés au plein emploi. On a aussi constaté que, en dehors des périodes de chocs de l’offre ou de la demande, il est tout à fait possible de maintenir l’inflation à un bas niveau même avec un taux de chômage historiquement peu élevé. Les auteur·es reviennent ensuite sur les autres constats faits dans ce document sur les avantages du plein emploi, surtout pour les groupes défavorisés. Les auteur·es concluent que «le maintien de marchés du travail serrés doit être un objectif politique majeur des administrations des États-Unis» et que «les économistes et les décideur·euses politiques doivent utiliser les outils politiques à leur disposition pour atteindre le plein emploi et y demeurer».

Et alors…

J’ai trouvé ce texte intéressant sous plusieurs aspects, aussi bien sur l’analyse des indicateurs pertinents, en soulignant notamment que le taux de chômage est un indicateur limité pour déceler la présence du plein emploi, que sur celle des effets bénéfiques du plein emploi, surtout pour les personnes faisant partie d’un groupe historiquement défavorisé. Ce contenu est encore plus appréciable quand on considère qu’il vient d’un organisme consultatif du président des États-Unis, et non pas d’un institut de recherche de gauche (même s’il y en a qui sont excellents!). Si seulement les recommandations de ce rapport pouvaient être suivies… À suivre!

Une année de détox vestimentaire

Avec son livre Une année de détox vestimentaire – Réflexions sur le prêt-à-jeter, Valérie Simard, journaliste à La Presse depuis 2007, lance «une invitation à une prise de conscience collective autant sur l’emprise de l’industrie de la mode que sur les forces internes et externes qui influencent nos décisions et nous poussent à la consommation». Elle propose aussi «des pistes de réflexion pour adopter une garde-robe plus responsable, en achetant moins, mais mieux».

Avec son livre Une année de détox vestimentaire – Réflexions sur le prêt-à-jeter, Valérie Simard, journaliste à La Presse depuis 2007, lance «une invitation à une prise de conscience collective autant sur l’emprise de l’industrie de la mode que sur les forces internes et externes qui influencent nos décisions et nous poussent à la consommation». Elle propose aussi «des pistes de réflexion pour adopter une garde-robe plus responsable, en achetant moins, mais mieux».

Introduction : Conscientisée depuis quelques années à sa surconsommation de vêtements, l’autrice a décidé de franchir un nouveau pas en relevant le défi de ne pas en acheter pendant un an. Elle présente des données montrant que la consommation de vêtements par habitant a augmenté de 60 % entre 2000 et 2014. Son livre est un appel à la réduction.

1. Des motivations au défi : «Le vêtement le plus écoresponsable est celui qui se trouve déjà dans votre garde-robe». Même si les conséquences du réchauffement climatique sont déjà catastrophiques et qu’elles rehaussent notre niveau d’écoanxiété, nous continuons à surconsommer tout en nous plaignant de l’inflation. Le défi que l’autrice s’est donné est une façon pour elle, probablement la seule, pour entamer une réflexion sur sa relation avec les vêtements et pour résister aux tentations liées à ses désirs et habitudes, et exacerbées par la publicité et les reportages sur la mode. Elle explique ensuite les événements qui l’ont incitée à se lancer ce défi; fournit des données sur l’ampleur de la production de textiles et de vêtements, et des dégâts environnementaux que cette production et sa consommation causent, dégâts amplifiés par la mode éphémère (fast fashion); aborde le rebond des ventes de vêtements après la période de confinement et de télétravail, et l’impact de ce défi sur la baisse de ses autres dépenses et sur le temps qu’elle a gagné pour faire autre chose.

2. Histoires de sevrage : Après avoir fait le tour de ses vêtements et constaté qu’elle manquait seulement de quelques t-shirts, elle décide d’en acheter et de commencer ensuite son défi, qu’elle n’entrevoyait finalement pas si difficile, malgré les commentaires de ses proches qui doutaient de son succès. Elle raconte ensuite des expériences semblables tentées par d’autres femmes, avec des succès variables, en soulignant les écueils possibles et les trucs qui aident à passer au travers. Dans certains cas, la fin du défi a été plus difficile que l’année sans achats, et dans d’autres, la surconsommation après le défi a plus qu’annulé l’absence d’achats pendant un an!

3. Les dessous d’une mode addictive : S’il est si difficile de s’empêcher d’acheter des vêtements, c’est en grande partie parce qu’ils n’ont pas qu’une fonction utilitaire. Dès la préhistoire, ils avaient aussi des fonctions symboliques, notamment identitaires et sociales. L’autrice aborde aussi «les mécanismes psychologiques derrière la consommation»; le rôle du striatum et de la dopamine dans les pulsions d’achat; l’élasticité du concept de besoin, trop souvent confondu avec celui de désir; les raisons qui expliquent que l’achat de vêtement est un besoin (ou un désir) plus souvent féminin que masculin.

4. La publicité et les réseaux sociaux – fabriques de désir : Abonnée avant son défi à une vingtaine d’infolettres sur la mode et les vêtements, l’autrice a reçu le conseil avisé de se désabonner de ces lettres, ce qu’elle a fait. Elle aborde ensuite les points communs entre la publicité et la propagande; la liberté de choix relative en matière de consommation; le caractère anxiogène de la surconsommation; la fuite en avant des accros au changement de vêtements.

5. Du prêt-à-porter au prêt-à-jeter : «Le lancement de nouvelles collections n’est depuis longtemps plus limité aux changements de saison» et aux événements saisonniers (fin de l’année scolaire, temps des Fêtes, etc.), en raison de l’émergence de la mode rapide ou éphémère (fast fashion). Les marques de vêtements peuvent maintenant sortir de 12 à 20 collections par année. Et on observe depuis quelques années une accélération de ce rythme avec la mode ultra rapide ou ultra éphémère (ultra fast fashion), encore plus polluante et avec des employé·es encore plus exploité·es. L’autrice aborde aussi les coûts sociaux des bas prix et l’obsolescence programmée.

6. Des solutions de rechange pour se vêtir autrement : L’autrice est membre d’un club d’échange de vêtements depuis quelques années et sa fréquentation durant son année sans achats a selon elle été sa planche de salut. Après avoir présenté les avantages et désavantages de ces clubs, elle aborde la location pour les grandes occasions (qu’elle a utilisée deux fois pour des mariages lors de son année sans achats) et l’achat de vêtements usagés, par exemple dans les friperies (à utiliser avec parcimonie si notre objectif est environnemental).

7. Reporter ses vêtements, un acte militant : L’autrice explore différentes sources pour savoir combien de fois un vêtement est reporté en moyenne, et obtient des résultats très différents selon les sources. Elle en a aussi discuté avec des professionnelles de la mode, encore là, avec des écarts importants, mais obtient des conseils sur la façon de reporter des vêtements en les agençant autrement. Elle aborde aussi les arguments de mouvements créés pour inciter à porter des vêtements plusieurs fois, notamment le gain de temps et une baisse du stress quotidien.

8. Une année à renoncer – les tentations au rythme du calendrier : L’autrice raconte son passage dans un centre d’achats un mois avant la fin de son défi. Cela dit, aucun magasin et aucune vitrine ne l’attirait. C’est justement ce sentiment de manque ou d’absence de désir qu’elle a trouvé le plus difficile à vivre. Elle décrit ensuite les moments de l’année qui furent pour elle les plus difficiles à traverser (changements de saisons, soldes de fin de saison, événements spéciaux, etc.).

9. Des initiatives locales prometteuses : Elle qui pensait s’offrir un vêtement spécial dès le premier jour suivant la fin de son défi, l’autrice s’est sentie paralysée devant le choix qui s’offrait à elle. Cela lui a pris deux mois pour acheter un nouveau vêtement neuf. Elle avait développé un rapport tout à fait différent avec les vêtements. Elle cherchait dorénavant des vêtements plus durables. Elle présente ensuite une conceptrice qui vend ses vêtements plus chers, mais très durables, souvent fabriqués sur mesure; d’autres conceptrices qui fabriquent leurs vêtements avec des fibres venant du Québec; d’autres encore qui n’utilisent que des fibres naturelles et évitent les déchets.

10. Pour une garde-robe responsable : Il est très difficile pour les consommateur·trices de connaître l’empreinte environnementale d’un vêtement et les conditions de travail des personnes qui l’ont produit. On ne peut surtout pas se fier aux affirmations des marques qui vantent la durabilité de leurs méthodes de production et l’éthique dont elles font preuve avec leurs employé·es. Une recherche récente a montré qu’au moins 60 % des allégations des marques sont fausses ou trompeuses. L’autrice présente une série d’évaluations faites sur des sites Internet avec le sens précis des termes utilisés. Comme bien des analystes, l’autrice constate qu’il n’existe pas de vêtement idéal. Tous ont un impact environnemental. Le meilleur moyen de minimiser cet impact est donc de garder ses vêtements longtemps et d’en acheter des neufs le moins possible. Dans ce contexte, le vêtement le plus responsable est celui qui contribue à réduire notre consommation future. Il doit donc être durable et correspondre à nos goûts et non à la tendance du moment. Elle donne ensuite des conseils pour réduire au minimum les infolettres auxquelles nous ne sommes pas toujours conscient·es de s’abonner; pour ne conserver que les vêtements qui nous plaisent; pour bien choisir les vêtements à conserver ou à acheter; pour vérifier la qualité des coutures; pour apprendre à bien entretenir et à réparer ses vêtements.

Conclusion : Ses amies ont été surprises de savoir que l’autrice n’a pas fait la tournée des magasins à la fin de son année sans achats. Avec toute l’information qu’elle a amassée et dont elle nous a fait le résumé dans ce livre, elle n’avait pas vraiment le goût de reprendre ses vieilles habitudes qu’elle a eu tant de difficulté à mettre de côté pendant cette année. Elle revient sur ses principaux constats, recommande quelques réglementations nécessaires pour rendre l’industrie moins gaspilleuse et dommageable pour l’environnement, propose quelques questions à se poser avant de se procurer un vêtement et imagine la garde-robe la plus respectueuse possible des limites de l’environnement. Elle conclut finalement que la mode passe, mais son impact demeure…

Et alors…

Lire ou ne pas lire? Lire! Je dois avouer être sidéré par la superficialité des personnes qui tiennent absolument à changer de vêtements fréquemment et encore plus par celles qui font des pressions dans ce sens. Je comprends très bien que les femmes subissent bien plus ces pressions que les hommes, mais quand même. Ce comportement me semble dépendre du milieu dans lequel on se tient. D’ailleurs, ma conjointe dit n’avoir jamais senti ce genre d’obligation. Ça m’a fait penser à des échanges que j’ai déjà entendus sur le port de bas blancs qu’il faut absolument éviter… C’est ce que je porte tout le temps ou presque (pire, je coupe leurs hauts élastiques pour qu’ils ne me serrent pas les jambes!)… Ça m’a aussi rappelé un texte que j’ai écrit et distribué avec des amis à l’université, texte que nous avions intitulé Le manifeste des antichromés… Bref, j’ai beaucoup aimé ce livre, même s’il ne s’adresse manifestement pas à moi ni à mes proches! Je peux au moins mieux comprendre la charge mentale que subissent des personnes et des vedettes à ce propos, surtout encore une fois des femmes. Je ne peux que compatir avec elles. Cela dit, rien n’est parfait, car les 79 notes, surtout des références, mais aussi quelques compléments d’information, sont à la fin du livre.

J’ai présenté il y a un an une étude montrant que les salaires horaires ont augmenté davantage chez les bas salarié·es que la moyenne au cours des années qui ont précédé et suivi l’arrivée de la pandémie de COVID-19 (de janvier 2015 à décembre 2022). Par contre, les auteur·es soulignaient les limites de leur étude en raison de la petitesse des échantillons utilisés. Je trouve donc pertinent de revenir sur le sujet avec une autre étude sur le sujet. Le document d’Elise Gould et de Katherine deCourcy intitulée Fastest wage growth over the last four years among historically disadvantaged groups (La croissance salariale a été plus rapide au cours des quatre dernières années parmi les groupes historiquement défavorisés) a été publié par l’Economic Policy Institute (EPI) le 21 mars dernier.

J’ai présenté il y a un an une étude montrant que les salaires horaires ont augmenté davantage chez les bas salarié·es que la moyenne au cours des années qui ont précédé et suivi l’arrivée de la pandémie de COVID-19 (de janvier 2015 à décembre 2022). Par contre, les auteur·es soulignaient les limites de leur étude en raison de la petitesse des échantillons utilisés. Je trouve donc pertinent de revenir sur le sujet avec une autre étude sur le sujet. Le document d’Elise Gould et de Katherine deCourcy intitulée Fastest wage growth over the last four years among historically disadvantaged groups (La croissance salariale a été plus rapide au cours des quatre dernières années parmi les groupes historiquement défavorisés) a été publié par l’Economic Policy Institute (EPI) le 21 mars dernier.

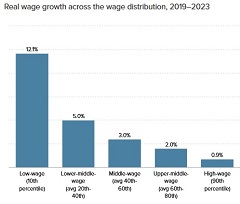

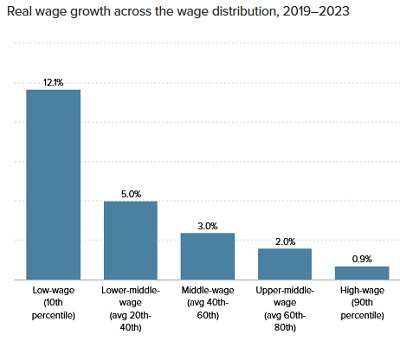

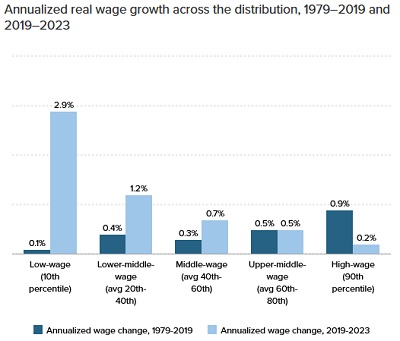

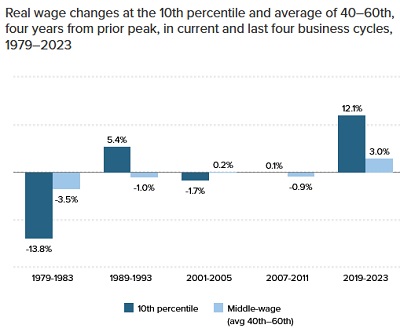

Introduction : Entre 1979 et 2019, les travailleur·euses à bas et moyens salaires n’ont connu aux États-Unis que quelques courtes années de forte croissance des salaires horaires réels (corrigés de l’inflation). Mais cette tendance a changé par la suite, entre 2019 et 2023, comme nous le verrons bientôt.